计算机毕业设计Hadoop+Spark股票预测系统 量化交易分析 股票可视化 大数据毕业设计(源码+文档+PPT+讲解)

计算机毕业设计Hadoop+Spark股票预测系统 量化交易分析 股票可视化 大数据毕业设计(源码+文档+PPT+讲解)

温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+Spark股票预测系统、量化交易分析与股票可视化技术说明

一、引言

在当今数字化金融时代,股票市场数据呈爆炸式增长,传统分析方法难以高效处理海量数据并挖掘潜在价值。Hadoop和Spark作为大数据处理领域的核心框架,凭借其强大的分布式存储与计算能力,为股票市场分析提供了创新解决方案。本技术说明旨在详细阐述基于Hadoop和Spark的股票预测系统、量化交易分析以及股票可视化的实现原理、技术架构与应用流程。

二、技术架构

(一)数据采集层

利用Python的requests库编写爬虫程序,从金融数据API(如Tushare、Alpha Vantage)、财经网站以及社交媒体平台(如Twitter)等多源渠道收集股票相关数据。这些数据涵盖股票价格、成交量、财务指标、新闻资讯以及投资者情绪等多维度信息,为后续分析提供丰富的数据基础。

(二)数据存储层

采用Hadoop的分布式文件系统(HDFS)对采集到的海量股票数据进行存储。HDFS具备高容错性和高吞吐量的特性,能够确保数据的可靠性和可扩展性。通过将数据分散存储在多个节点上,有效避免了单点故障,保障了数据的安全性和可用性。

(三)数据处理层

利用Spark进行数据清洗、转换和预处理。Spark基于内存计算,相比传统的Hadoop MapReduce具有更高的计算效率。在数据清洗阶段,通过Spark的RDD(弹性分布式数据集)操作,去除数据中的噪声、异常值和重复记录。在数据转换阶段,对数据进行标准化、归一化处理,并提取关键特征,如移动平均线、相对强弱指数(RSI)等技术指标,以及通过自然语言处理(NLP)技术从新闻和社交媒体文本中提取的情感特征。

(四)分析与建模层

- 股票预测:基于Spark的机器学习库(MLlib),构建多种股票预测模型,如线性回归、决策树、随机森林以及深度学习模型(如LSTM)。利用历史数据对模型进行训练,通过交叉验证等方法优化模型参数,提高预测准确性。

- 量化交易分析:结合传统金融理论和机器学习算法,设计量化交易策略。例如,采用均值回归策略,基于股票价格围绕均值波动的假设,当价格偏离均值超过一定阈值时进行买卖操作。同时,利用Spark Streaming对实时股票数据进行处理和分析,及时发现交易机会并执行交易。

(五)可视化层

使用ECharts等可视化工具,将股票预测结果、量化交易分析数据以及股票市场动态以直观的图表形式展示。通过前端技术(如HTML、CSS、JavaScript)构建交互式可视化界面,用户可以方便地查看股票价格走势、成交量变化、技术指标分析以及交易信号等信息,为投资决策提供有力支持。

三、关键技术实现

(一)数据清洗与特征提取

- 数据清洗:利用Spark的RDD操作,对采集到的原始数据进行过滤、转换和聚合。例如,使用

filter函数去除缺失值和异常值,使用map函数对数据进行格式转换,使用reduceByKey函数对数据进行聚合统计。 - 特征提取:针对股票数据的特点,提取多种技术指标和文本特征。技术指标方面,计算移动平均线(MA)、相对强弱指数(RSI)、布林带(Bollinger Bands)等;文本特征方面,利用Spark NLP库对新闻和社交媒体文本进行分词、词性标注和情感分析,提取关键词和情感得分。

(二)模型训练与评估

- 模型训练:使用Spark MLlib提供的机器学习算法接口,对提取的特征数据进行模型训练。例如,对于线性回归模型,使用

LinearRegression类进行训练;对于LSTM模型,结合TensorFlow或PyTorch等深度学习框架,利用Spark的分布式计算能力进行模型训练。 - 模型评估:采用多种评估指标对训练好的模型进行评估,如均方误差(MSE)、平均绝对误差(MAE)、准确率(Accuracy)、召回率(Recall)等。通过评估结果,选择最优的模型进行部署和应用。

(三)量化交易策略实现

- 策略设计:根据投资目标和风险偏好,设计个性化的量化交易策略。例如,对于风险偏好较低的投资者,可以采用均值回归策略;对于风险偏好较高的投资者,可以采用动量策略。

- 策略回测:利用历史数据对设计的量化交易策略进行回测,评估策略的盈利能力和风险水平。回测过程中,考虑交易成本、滑点等因素对策略绩效的影响。

- 实时交易:将优化后的量化交易策略部署到实际交易环境中,利用Spark Streaming对实时股票数据进行处理和分析。当满足交易条件时,自动执行交易操作,并通过风险监控系统实时监测交易风险。

(四)可视化展示

- 图表绘制:使用ECharts提供的丰富图表类型,如折线图、柱状图、散点图、K线图等,绘制股票价格走势、成交量、技术指标等图表。

- 交互设计:通过前端技术实现交互式可视化界面,用户可以进行数据筛选、图表缩放、数据对比等操作,深入探索股票数据的内在规律。

四、应用流程

- 数据采集与存储:按照预设的时间间隔,通过爬虫程序从多源渠道采集股票数据,并将数据存储到HDFS中。

- 数据处理与特征提取:利用Spark对存储在HDFS中的数据进行清洗、转换和特征提取,生成用于分析和建模的特征数据集。

- 模型训练与预测:使用特征数据集对股票预测模型进行训练,并利用训练好的模型对未来股票价格进行预测。

- 量化交易策略执行:根据量化交易策略和实时股票数据,生成交易信号并执行交易操作。

- 可视化展示:将股票预测结果、量化交易分析数据以及股票市场动态通过可视化界面展示给用户,为用户提供决策支持。

五、优势与挑战

(一)优势

- 高效处理海量数据:Hadoop和Spark的分布式架构能够高效处理PB级的股票数据,满足大数据时代股票市场分析的需求。

- 强大的计算能力:Spark基于内存计算,相比传统的Hadoop MapReduce具有更高的计算效率,能够快速完成数据分析和模型训练任务。

- 丰富的算法支持:Spark MLlib提供了多种机器学习算法,方便用户进行股票预测和量化交易分析。

- 直观的可视化展示:通过可视化技术,将复杂的股票数据以直观的图表形式展示,帮助用户更好地理解市场动态和投资机会。

(二)挑战

- 数据质量与一致性:多源数据的质量和一致性难以保证,需要进行复杂的数据清洗和整合工作。

- 模型复杂度与过拟合:股票市场具有高度的复杂性和不确定性,构建准确的预测模型具有挑战性,容易出现过拟合问题。

- 实时数据处理延迟:在实时交易场景中,需要保证系统的低延迟和高并发处理能力,对技术架构和算法优化提出了更高的要求。

六、结论

基于Hadoop和Spark的股票预测系统、量化交易分析与股票可视化技术为股票市场分析提供了强大的工具和方法。通过充分利用大数据技术的优势,能够挖掘股票数据中的潜在价值,为投资者提供更准确的预测、更科学的交易策略和更直观的可视化展示。然而,该技术也面临着数据质量、模型复杂度和实时性等方面的挑战。未来,随着技术的不断发展和创新,相信这些问题将得到逐步解决,该技术将在股票市场分析领域发挥更加重要的作用。

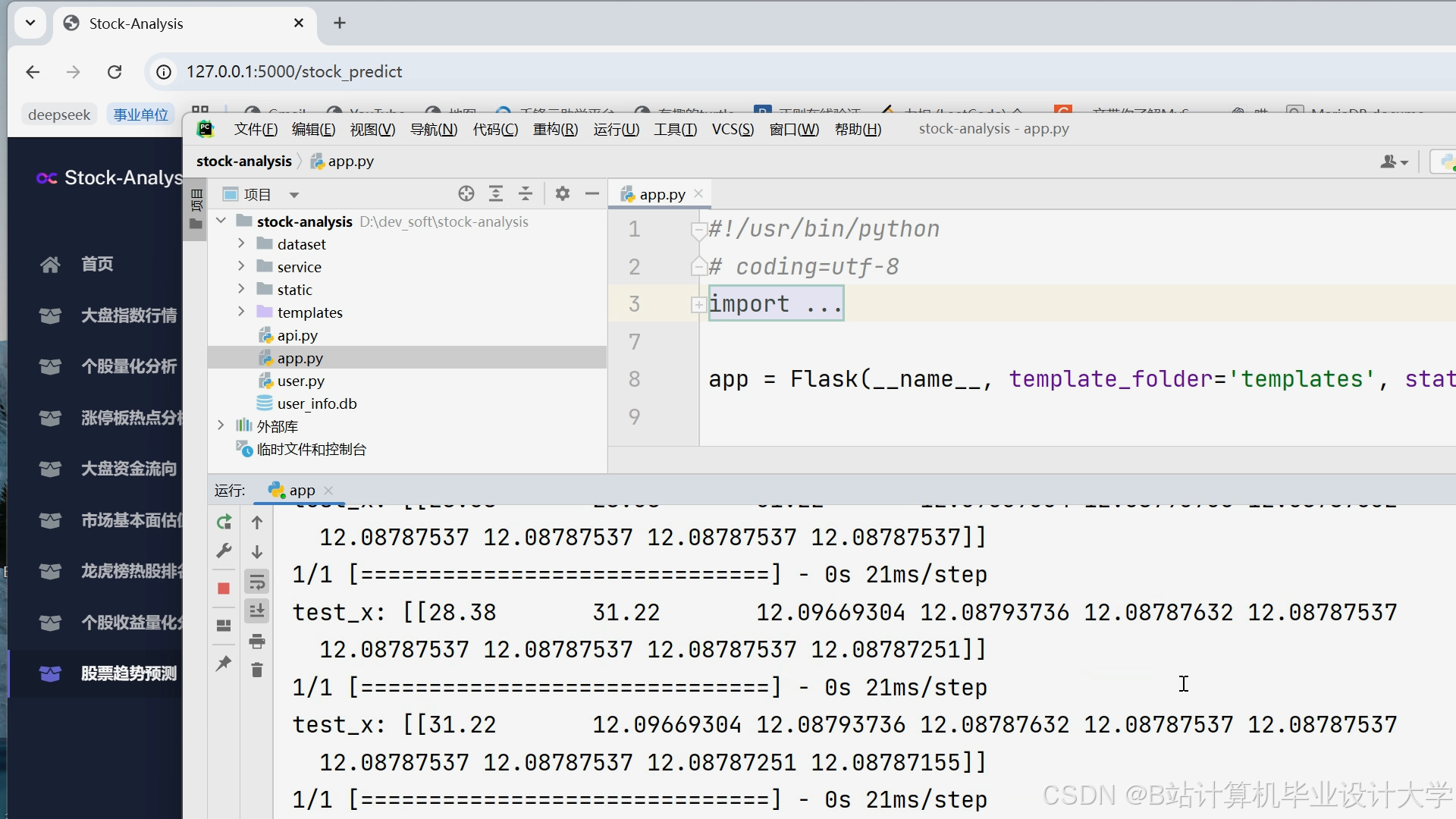

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

更多推荐

已为社区贡献105条内容

已为社区贡献105条内容

所有评论(0)