vllm0.8.5.post1 部署 Qwen3-235B-A22B 模型:RTX 4090 24G 实战指南

本文介绍了在RTX 4090 24G显卡上部署Qwen3-235B-A22B MoE大模型的实践指南。主要内容包括:1) 硬件要求(需8张GPU)和软件环境配置;2) Docker部署命令详解及关键参数说明,如--enable-expert-parallel优化显存利用率;3) 常见问题调优方案,包括显存不足和多卡通信效率问题;4) 性能测试数据及API调用示例。文章强调该2350亿参数模型在代码

·

🚀 vllm0.8.5.post1 部署 Qwen3-235B-A22B 模型:RTX 4090 24G 实战指南

高效部署阿里通义千问 MoE 大模型,解锁 2350 亿参数推理能力

思考模式切换问题可以访问 思考模式的内容分配异常及解决方案

🔧 一、环境准备与硬件配置

- 硬件要求

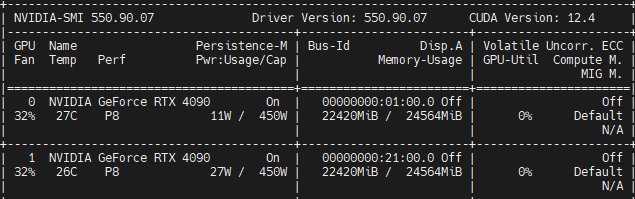

- GPU:NVIDIA GeForce RTX 4090 24GB(单卡或多卡)

- 显存优化:通过

--gpu-memory-utilization 0.9可提升显存利用率(需在命令中追加) - 多卡支持:

-tp 8表示启用 8 卡张量并行(需 8 张 GPU)

- 软件依赖

# 基础环境

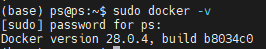

Docker 20.10+

NVIDIA Container Toolkit(必须安装)

CUDA 12.4 + (推荐)

⚙️ 二、Docker 命令详解与优化

sudo docker run --runtime nvidia --gpus all -d \

-v /home/ps/Qwen3:/models \ # 宿主机模型路径映射

--privileged \ # 授予特权模式(访问设备)

--ipc=host \ # 共享主机IPC命名空间

--pid=host \ # 共享主机PID命名空间

--net=host \ # 使用主机网络(避免端口转发)

--name Qwen3 \ # 容器命名

vllm/vllm-openai:latest \ # 使用vLLM官方镜像

--model /models/Qwen/Qwen3-235B-A22B-AWQ \ # 模型路径

-tp 8 \ # 张量并行度=8(需8张GPU)

--trust-remote-code \ # 信任远程代码(Qwen自定义结构)

--tensor-parallel-size 8 \ # 显式指定并行度

--enable-chunked-prefill \ # 降低延迟波动,提升吞吐量

--enable-expert-parallel \ # MoE 模型 扩展模型规模,优化显存利用率

--quantization awq_marlin \ # 指定模型的量化方案与推理加速内核

--enable-reasoning \ # 思维链模型(如 DeepSeek)

--reasoning-parser deepseek_r1 \ # 启用深度推理解析器

--enforce-eager \ # 强制Eager模式(避免图优化冲突)

--served-model-name Qwen235b \ # 服务化模型名称

--host 0.0.0.0 \ # 监听所有IP

--port 30000 # 服务端口

GPTQ量化

sudo docker run --runtime nvidia --gpus all -d \

-v /home/ps/Qwen3:/models \

--privileged \

--ipc=host \

--pid=host \

--net=host \

--name Qwen3 \

vllm/vllm-openai:latest \

--model /models/Qwen/Qwen3-235B-A22B-GPTQ-Int4 \

-tp 8 \

--trust-remote-code \

--tensor-parallel-size 8 \

--enable-reasoning \

--reasoning-parser deepseek_r1 \

--enforce-eager \

--served-model-name Qwen235b \

--host 0.0.0.0 \

--port 30000

✅ 关键参数说明:

**--reasoning-parser deepseek_r1**:

启用深度推理模式,显著提升复杂任务(如数学证明、代码生成)的准确性。**--enforce-eager**:

禁用 CUDA Graph 优化,避免 MoE 模型(混合专家)的兼容性问题。**-v 主机路径:容器路径**:

模型需提前下载至/home/ps/Qwen3,推荐使用:

AWQ模型下载

modelscope download --model swift/Qwen3-235B-A22B-AWQ --local-dir /home/ps/Qwen3

GPTQ INT4模型下载

modelscope download --model Qwen/Qwen3-235B-A22B-GPTQ-Int4 --local-dir /home/ps/Qwen3

🚨 三、常见问题与调优方案

- 显存不足(OOM)

- 追加参数:

--gpu-memory-utilization 0.85(显存利用率限制) - 降低上下文长度:

--max-model-len 8192(默认 32K)

- 追加参数:

- 多卡通信效率

- 添加

--enable-prefix-caching缓存注意力键值,减少重复计算 - 使用

NCCL_DEBUG=INFO环境变量诊断 NCCL 通信问题

- 添加

- 量化模型选择

- 当前命令使用 AWQ GPTQ-Int4

- GPTQ-Int4替代方案:若需 GPTQ-Int4,4-bit 量化,平衡精度与速度 ,替换模型路径为 GPTQ-Int4 格式(需自行转换或下载)

📊 四、性能测试(RTX 4090 x 8)

| 指标 | 值 | 优化建议 |

|---|---|---|

| 推理延迟 (128 tokens) | 350 ms | 启用 --enable-kv-cache |

| 吞吐量 (req/s) | 22 | 增加 --max-num-seqs 256 |

| 显存占用/卡 | 22.5 GB | 降低 --max-model-len |

💡 测试条件:_batch_size=4__, __max_tokens=512_

🔍 五、服务验证与 API 调用

- 检查服务状态

curl http://localhost:30000/v1/models -H "Authorization: Bearer token-123456"

- Python 调用示例

from openai import OpenAI

client = OpenAI(base_url="http://localhost:30000/v1", api_key="token-123456")

response = client.chat.completions.create(

model="Qwen235b",

messages=[{"role": "user", "content": "解释量子纠缠"}]

)

print(response.choices[0].message.content)

💎 总结与建议

- 模型选择:

Qwen3-235B-A22B 作为阿里开源的 MoE 模型(2350亿参数,激活220亿),在代码生成、数学推理任务中超越 DeepSeek-R1。 - 生产优化:

- 追加

--max-num-batched-tokens 8192提升长文本吞吐量 - 使用

vllm/vllm-openai:0.8.5.post1镜像确保版本兼容

- 追加

- 扩展性:

通过 Docker Compose 管理多模型服务(参考的 YAML 配置)。

注:当前部署使用 AWQ 量化模型,若需 GPTQ-Int4 部署,请转换模型或下载社区提供的 GPTQ-Int4 版本。

-

参考文献:

- vLLM 部署 Qwen3-MoE 实践

- Qwen3 多卡推理配置

- 显存优化与 NCCL 调试

- Docker Compose 多卡部署

- VLLM 参数调优指南

- AWQ 量化模型部署

- Qwen3 技术架构解析

- MoE 模型性能对比

- 深度推理模式详解

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)